[2019 CVPR] A General and Adaptive Robust Loss Function

Table of content (short-version) [paper] [github]

Summary

- CVPR oral

- Ground truth에서 많이 벗어난 outlier를 쳐내는 outlier suppression 관련 loss (e.g., registration and clustering)

- 여러개의 loss function이 존재하는데 이를 일반화하여 하나로 묶는 supervised loss function을 설계

- Cauchy/Lorentzian

- Geman-McClure

- Welsch/Leclerc

- Generalized Charbonnier

- Charbonnier/pseudo-Huber/L1-L2

- L2 loss function

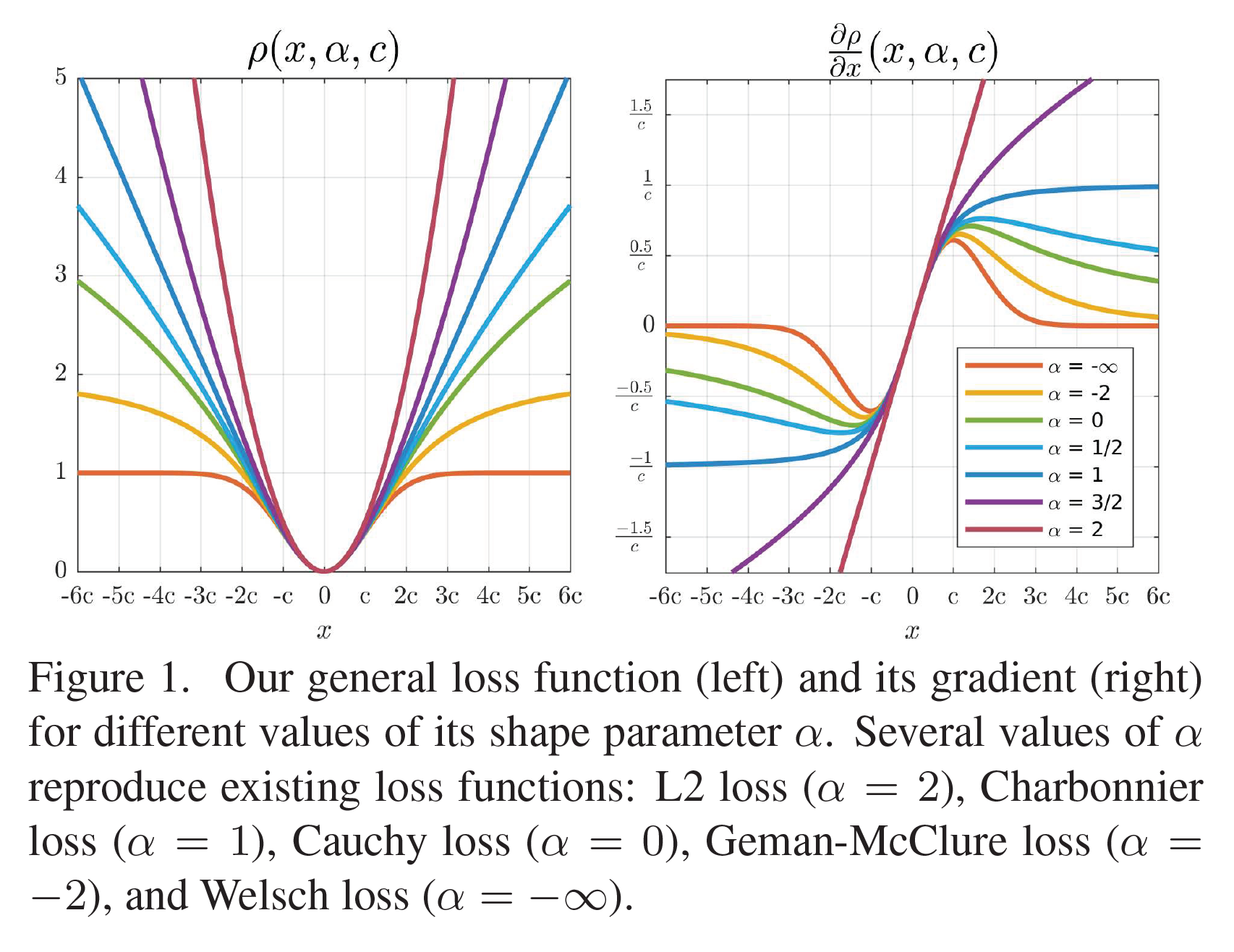

- Alpha(-inf~inf)와 c가 포함된 간단한 버전의 loss function 설명하고 이는 여러가지 loss function의 일반화 버전이라는 점을 강조

[Loss function]

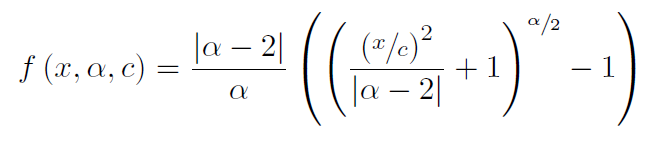

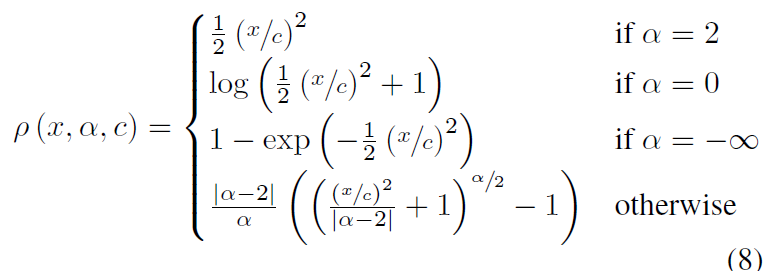

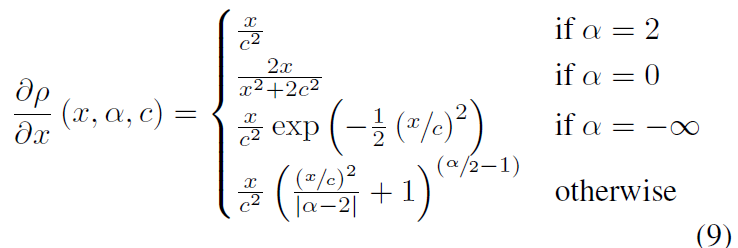

- 이 simplified loss function은 alpha가 2에 가까워지면서 explosion하는데 consistency 유지할 수 있게끔 다시 설계하고 그에 따른 gradient 제시

[Simplified loss]

[New loss]

[Gradient]

- 이 loss가 왜 stable한지(안정화 범위 제공), alpha는 어떻게 정해야 하는지 본문에 설명

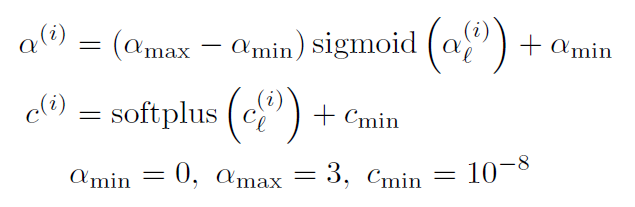

- Alpha를 정하지 않은채 범위만 주고 네트워크가 찾아내도록 설계하면 더 좋은 성능을 보임 (alpha와 c를 iterative 하게 업데이트 하는 방식)

[Alpha and c]

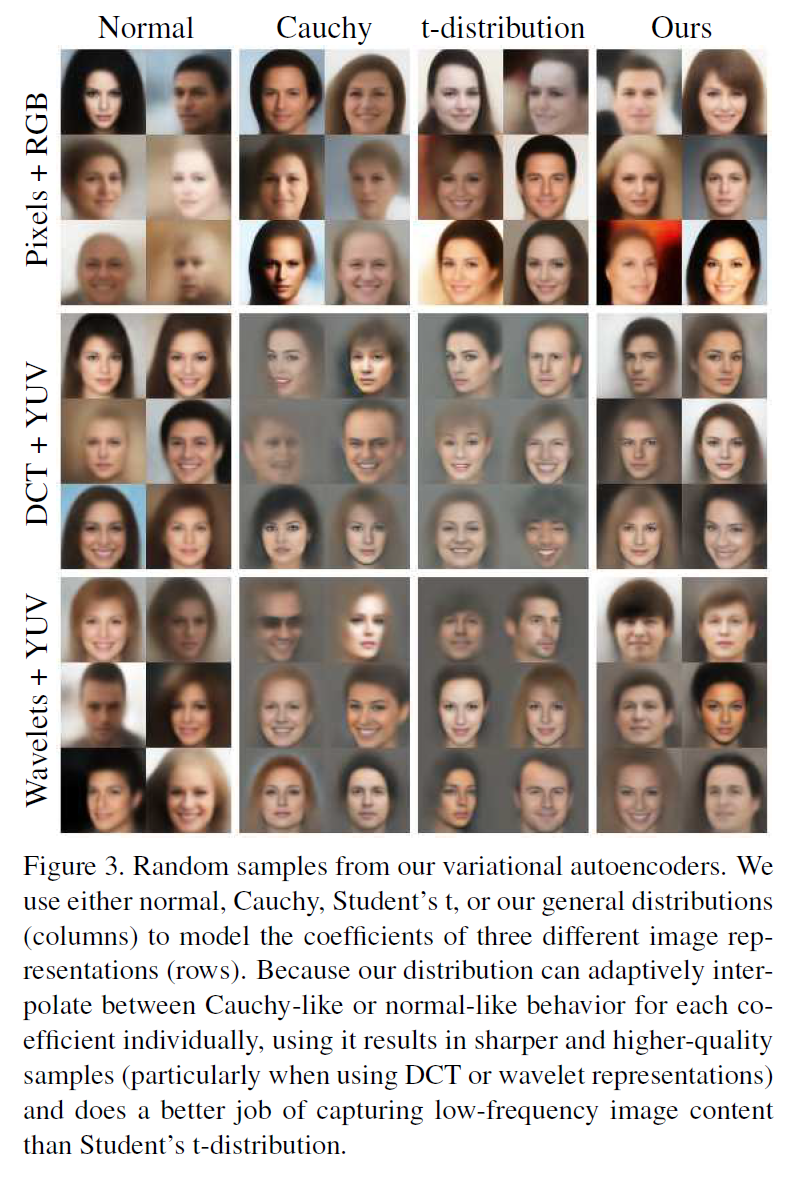

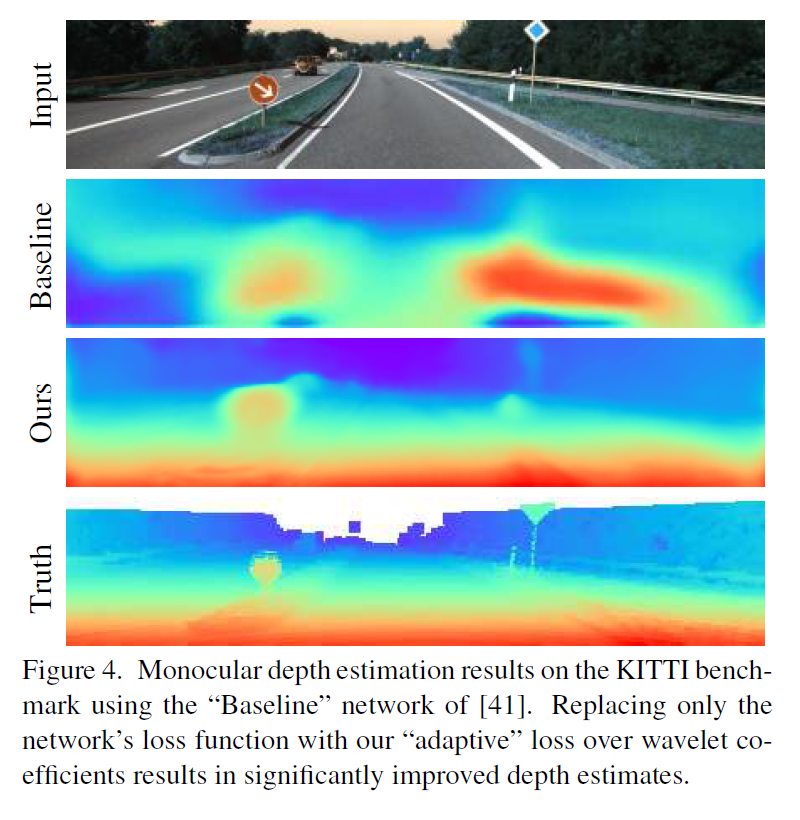

- Generative image synthesis와 unsupervised monocular depth estimation과 같은 학습기반 분야에서 높은 성능 향상 보임

[Generative image synthesis 결과]

[Unsupervised monocular depth estimation 결과]

- Tensorflow/pytorch에서 모델화가 되어있음

References

[1] Barron, Jonathan T. “A general and adaptive robust loss function.” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019.